GPT-5.3-Codex-Spark: un modelo ultrarrápido de OpenAI y Cerebras

16:36, 13.02.2026

OpenAI ha lanzado una versión especializada para la generación de código a alta velocidad: GPT-5.3-Codex-Spark. Esta novedad destaca por su increíble rapidez, ya que el modelo puede emitir más de 1000 tokens por segundo.

Rendimiento de Spark

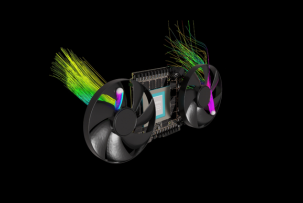

El rendimiento de Spark ha sido posible gracias al abandono de las GPU tradicionales en favor de los chips especializados Cerebras Wafer Scale Engine 3. Gracias a la nueva arquitectura y a una conexión WebSocket permanente, la latencia en la entrega de tokens se ha reducido en un 80%.

Este lanzamiento es el primer resultado de la colaboración entre OpenAI y Cerebras; no obstante, se trata de una versión de GPT-5.3-Codex y no de un modelo completamente nuevo. Spark ha sido diseñado con un enfoque en la programación en tiempo real y, por lo tanto, ofrece correcciones puntuales y adaptación de código 15 veces más rápido que los modelos convencionales.

Benchmarks

La velocidad fenomenal se equilibra con una menor precisión en las respuestas.

SWE-Bench Pro muestra que Spark resuelve una solicitud en 2–3 minutos con un resultado del 52%, mientras que el modelo superior alcanza el 57% pero tarda 16 minutos.

Terminal-Bench 2.0 indica que la precisión de las respuestas de Spark es del 58,4% frente al 77,3% del modelo insignia.

A pesar de esto, Spark supera significativamente al modelo GPT-5.1-Codex-mini. En Cerebras sugieren que el nuevo modelo podría convertir la respuesta instantánea en el nuevo estándar de la industria.

¿Cómo se puede probar Spark?

Actualmente, el modelo se encuentra en fase de "research preview" y está disponible para los suscriptores de ChatGPT Pro a través de CLI, una extensión para VS Code y la aplicación Codex. El modelo no admite imágenes y las API están abiertas solo para un círculo estrecho de socios.